Artículo

de Revisión

Gobernanza y desafíos éticos en la adopción empresarial

de la inteligencia artificial

Governance and ethical challenges in the business adoption of

the artificial intelligence

Darwin

Daniel Ordoñez Iturralde 1,a , Christian

Xavier Proaño Piedra 1,b

1

Universidad Laica Vicente Rocafuerte de Guayaquil, Guayaquil, Ecuador.

a

Doctor en Educación.

b

Magíster Universitario en Administración y Gestión Avanzada de Proyectos.

RESUMEN

Este

trabajo explora cómo la inteligencia artificial (IA) impacta en la gestión

empresarial a nivel internacional, examinando la equidad, gobernanza y desafíos

éticos que acarrea su adopción. Así mismo, se destaca cómo la fragmentación

regulatoria entre diferentes regiones, como la Unión Europea, Estados Unidos y

China, dificulta la creación de modelos coherentes de gobernanza y aumenta la

incertidumbre en las operaciones. Además, se abordan dilemas éticos como los

sesgos algorítmicos y la tensión entre la privacidad de los usuarios y la

personalización de los servicios. Se examinan estrategias de empresas líderes,

como la realización de auditorías algorítmicas y el establecimiento de

políticas de transparencia, que buscan fomentar la confianza del público y

mejorar la reputación corporativa. No obstante, obstáculos como la falta de

talento especializado y la resistencia interna de las organizaciones dificultan

la adopción de prácticas éticas sostenibles. Finalmente, este análisis sugiere

que las empresas que inviertan en marcos de gobernanza adaptativos y colaboren

con gobiernos y actores privados estarán mejor preparadas para enfrentar los

desafíos cambiantes de la IA y competir en el mercado global.

Palabras

clave:

inteligencia artificial; ética; gobierno; cooperación internacional; cambio

tecnológico.

ABSTRACT

This

work explores how artificial intelligence (AI) impacts business management to

international level, examining equity, governance and ethical challenges that

govern and ethical challenges that carry its adoption. It also highlights how

regulatory fragmentation between different regions, such as the European Union,

the United States and China, makes it difficult to create coherent models of

governance and increases uncertainty in the operations. In addition, ethical

dilemmas such as algorithmic biases and the tension between the privacy of the

users and the personalization of the services. It examines strategies of

leading companies, such as conducting algorithmic audits and establishing

transparency policies, that seek to build public trust and enhance corporate

reputation. However, obstacles such as lack of specialized talent and internal

organizational resistance hinder the adoption of sustainable ethical practices.

Finally, this analysis suggests that companies that invest in adaptive

governance frameworks and collaborate with governments and private actors will

be better prepared to meet the evolving challenges of AI and compete in the

global marketplace.

Keywords: artificial intelligence:

ethical; government; international cooperation; technological change.

Recibido:

24/06/24

Aprobado:

18/08/24

Publicado:

28/08/24

Citar como: Ordoñez Iturralde, D.,

y Proaño Piedra, C. (2024). Gobernanza y desafíos éticos en la adopción

empresarial de la inteligencia artificial. Innovación Empresarial, 4(2), e633. https://doi.org/10.37711/rcie.2024.4.2.633

INTRODUCCIÓN

La

rápida evolución de la inteligencia artificial (IA) transforma las prácticas

empresariales mediante la automatización de decisiones y la mejora en la toma

de decisiones y los procesos internos (Rana et al., 2022). Pero al mismo tiempo

plantea varios desafíos éticos y regulatorios, que incluyen, entre otros, la

necesidad de transparencia, protección de la privacidad y responsabilidad

algorítmica, la cual es especialmente relevante para las empresas internacionales

que deben cambiar constantemente y adaptarse para cumplir con unos marcos

legales en rápido desarrollo (Floridi y Cowls, 2019).

Desde

2016, numerosas organizaciones han manifestado su compromiso con los principios

de una inteligencia artificial responsable, priorizando valores como la

transparencia y la seguridad. Esto se ha reflejado en iniciativas como la

Partnership on AI (de Laat, 2021), que promueve la colaboración en este ámbito.

Al mismo tiempo, algunas empresas han apostado por desarrollar herramientas de

código abierto. Además, de Laat (2021) señaló que cerca de diez compañías,

tanto en Europa como en los Estados Unidos, han abogado por una regulación

gubernamental específica para aplicaciones consideradas de alto riesgo. Su

objetivo es encontrar un equilibrio entre la autorregulación del sector y la

implementación de prohibiciones estrictas que podrían frenar el desarrollo de

ciertas tecnologías.

La

IA tiene el potencial de hacer que una empresa sea más eficiente y más

competente; sin embargo, muchas organizaciones todavía no están listas para

hacerle frente a las crecientes exigencias de una IA responsable (Binns, 2018).

Esto debido a la falta de un regulador de mercado estable y la imposibilidad de

integrar normas éticas globales (Jobin et al., 2019). En consecuencia, esto

obliga a las empresas multinacionales a enfrentarse al desafío de la innovación

rápida (Dignum, 2019).

Esta

revisión analiza el panorama regulatorio emergente relacionado con la IA y su

impacto con la gestión empresarial internacional, explora estrategias de

adaptación, identifica tendencias y desafíos en el ámbito del cumplimiento de

normas y brinda una perspectiva crítica de la integración de la ética en el

proceso de toma de decisiones empresariales.

MÉTODOS

Para

llevar a cabo este estudio se realizó una búsqueda sistemática de artículos

científicos en las bases de datos ScienceDirect, Springer Link y Emerald

Insight, seleccionadas por su relevancia en los ámbitos académico y

empresarial. La búsqueda se limitó a publicaciones del período 2019-2023, para

asegurar que los hallazgos fueran actuales y reflejaran las tendencias más

recientes. Siguiendo los principios de Booth et al. (2016), la estrategia de

búsqueda empleó operadores booleanos con las palabras clave: “artificial

intelligence”, “business ethics”, “international regulation”, “responsible AI” y

“algorithmic risks.” La ecuación booleana

aplicada fue: “artificial intelligence” AND (“business ethics” OR

“responsible AI”) AND (“international regulation” OR “algorithmic risks”).

Para

asegurar la accesibilidad de las fuentes se aplicaron filtros que restringieron

los resultados a artículos revisados por pares y de acceso abierto. El enfoque

se centró en estudios que examinaran la aplicación ética de la inteligencia

artificial en empresas internacionales, incluyendo investigaciones empíricas y

marcos normativos en regiones clave como la Unión Europea y Estados Unidos.

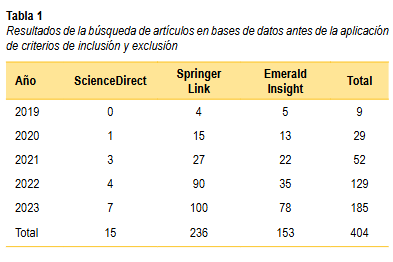

Inicialmente, la búsqueda recuperó 381 artículos en las tres bases de datos: ScienceDirect (6), Springer Link (223) y Emerald Insight (152). Posteriormente, se realizó una segunda búsqueda en Google Scholar para identificar artículos adicionales que correspondieran a las mismas bases de datos iniciales. Este paso permitió incorporar 25 estudios adicionales, elevando el total de artículos identificados a 404 (ver Tabla 1).

Los

artículos se sometieron a criterios específicos de inclusión y exclusión para

garantizar la relevancia y calidad de los estudios. Los criterios de inclusión

abarcaban estudios de acceso abierto y revisados por pares, que se basaban en

la ética de la IA en el ámbito empresarial, mientras que los criterios de

exclusión abarcaban estudios no prácticos e investigaciones no realizadas de

2019 a 2023.

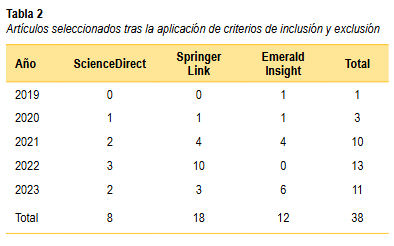

Tras

la aplicación de estos criterios fueron seleccionados 38 artículos relevantes,

distribuidos según se muestra en la Tabla 2.

DESARROLLO Y DISCUSIÓN

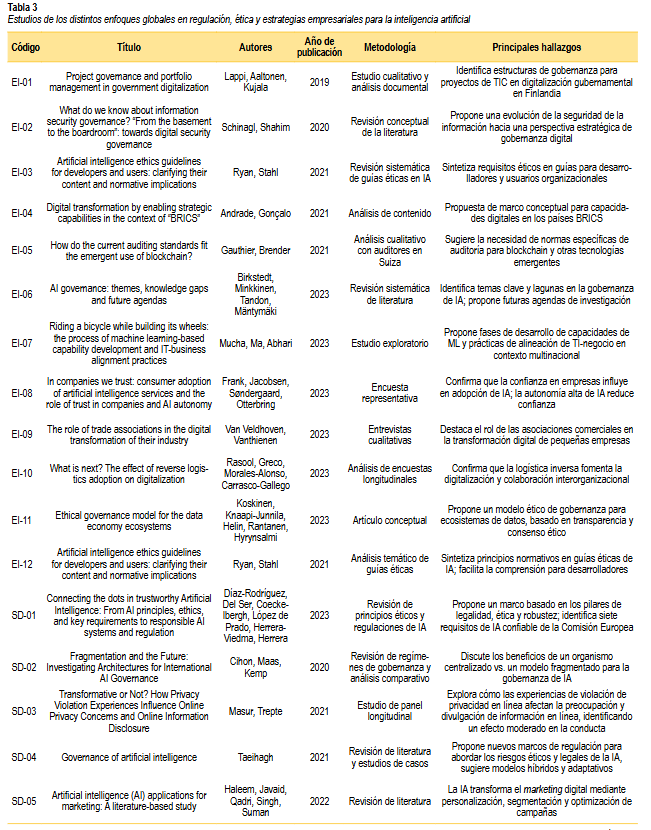

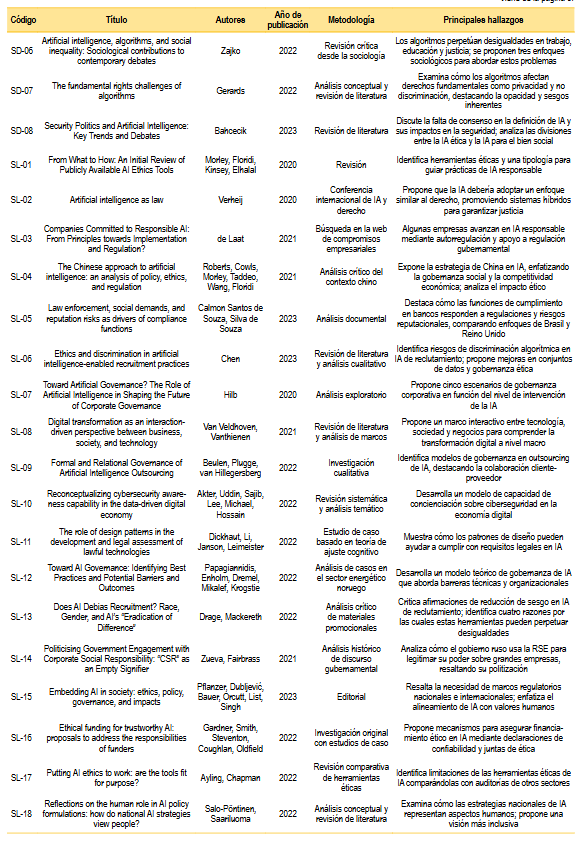

En este apartado se presentan los estudios encontrados en la revisión de la literatura, clasificados en tres áreas temáticas: regulación internacional emergente en IA, dilemas éticos y sesgos algorítmicos en empresas internacionales, y estrategias empresariales para la adopción de AI responsable (ver Tabla 3).

Regulación internacional emergente en inteligencia

artificial

A medida

que la regulación de la IA avanza, las diferencias regionales plantean desafíos

para las multinacionales. Por ejemplo, en la Unión Europea (UE), el AI Act

establece un marco regulatorio basado en el riesgo que supervisa las

aplicaciones de IA que afectan la seguridad y los derechos fundamentales

(European Commission, 2021). Este enfoque, abordado por autores como

Díaz-Rodríguez et al. (2023) y Bahcecik (2023), se apoya en tres pilares: la

legalidad, la ética y la solidez para aumentar la supervisión humana, la

transparencia y la rendición de cuentas por la discriminación algorítmica

(Veale y Zuiderveen, 2021); aunque un marco tan estricto podría limitar la

innovación de las empresas europeas en comparación con empresas de regiones con

regulaciones más flexibles (Espinoza, 2024; Roberts et al., 2021).

Estados

Unidos y China permiten mayor innovación, a pesar de sus gastos en seguridad y

responsabilidad algorítmica (Erdélyi y Goldsmith, 2022). Estados Unidos opta

por la autorregulación, emitiendo guías en el sector que enfatizan la seguridad

de los algoritmos (NIST, 2024). Así mismo, la Declaración de Derechos de la IA

(AI Bill of Rights) de 2023 establece cinco principios no violentos para

garantizar que los sistemas automatizados traten a las personas civilmente y

otorguen equidad (Park, 2023). Sin embargo, este enfoque flexible conduce a

riesgos de segregación algorítmica y desigualdad en la protección del

consumidor (Fjeld et al., 2020).

La

regulación estratégica de la IA en China, que se realizó con la participación

del control estatal, ha demostrado tener un impacto en la innovación en la

esfera de la atención médica y las herramientas de vigilancia (Ding, 2018). El

país también lidera la innovación global en IA a través del Plan de Desarrollo

de la IA de la Próxima Generación (New Generation Artificial Intelligence

Development Plan, AIDP) que combina incentivos económicos con supervisión

estatal (Roberts et al., 2021; Roberts et al., 2023). Este enfoque permite la

experimentación estratégica con tecnología; sin embargo, tiene limitaciones en

términos de transparencia y gobernanza ética, lo que según Mozur et al. (2019)

confiere a China una ventaja competitiva dada la recopilación de datos a gran

escala y la implementación de regulaciones adaptables. Finalmente, China

apalancó empresas privadas y políticas internas para proyectar su poder global para

desafiar el dominio estadounidense y promover un orden global multipolar

(Simbar y Moghadam, 2022).

La

diversidad de enfoques regulatorios en estas regiones es un obstáculo para las

empresas, que deben adaptar sus operaciones a las cambiantes normativas

locales. Esta fragmentación, explicada por Verheij (2020) y Jobin et al.

(2019), aumenta los costos operativos y crea incertidumbre, dificultando la

integración de estándares éticos y responsabilidad en diferentes

jurisdicciones. Como observaron Verheij (2020) y Papagiannidis et al. (2022),

es importante desarrollar estructuras de gobernanza interna adaptadas a un

entorno fragmentado y cambiante.

El

sector sanitario aporta oportunidades a través de la aplicación de técnicas de

AI que transforman el flujo de trabajo y la relación médico-paciente, aunque

enfrentan retos de privacidad y transparencia, según señalan autores como

Mennella et al. (2024) y Díaz-Rodríguez et al. (2023). Por su parte, la

regulación europea garantiza la seguridad de los pacientes y la privacidad de

los datos. Una regulación flexible promueve la innovación y aborda los riesgos

algorítmicos y de privacidad (Mennella et al., 2024). Taeihagh (2021) también

resalta que la gobernanza adaptativa es necesaria para abordar los riesgos de

la IA e involucrar a los actores no estatales en la toma de decisiones.

En

línea con las estrategias nacionales de digitalización Lappi et al. (2019)

enfatizan la relevancia de la gestión de cartera en la gobernanza multinivel de

proyectos de tecnología de la información (TI) en Finlandia. Mientras que

Gauthier y Brender (2021) recomiendan desarrollar nuevos estándares de

auditoría de TI para seguir la evolución de las nuevas tecnologías,

especialmente blockchain, para aprovechar la gestión de riesgos en la

digitalización de la economía. Por otro lado, Ryan y Stahl (2021) tratan sobre

cómo las conductas éticas en IA pueden enseñar a los desarrolladores conductas

que sugieren, como el uso de patrones de diseño para cumplir con las

regulaciones; tal es el caso del Reglamento General de Protección de Datos de

la Unión Europea.

Birkstedt

et al. (2023) abordan la implementación de la IA en el nivel organizativo,

enfocado en alinear los valores tecnológicos y éticos, y sugieren una agenda de

investigación. El marco legal de los requisitos del sistema de IA se mejorará a

través de patrones de diseño y principios éticos, para ayudar a desarrolladores

y expertos legalmente calificados a idear soluciones de cumplimiento (Dickhaut

et al., 2022). La IA también debe adoptar principios éticos para minimizar los

riesgos sociales y garantizar la implementación ética, como discuten Pflanzer

et al. (2023).

Equilibrar

la tecnología y la integración de personas y relaciones es esencial para una gestión

eficaz de la inteligencia artificial (Salo-Pöntinen y Saariluoma, 2022).

Incluso si no existe una cultura global uniforme, las empresas que se

encuentren en ella podrán aislarse y descuidar sus negocios (Floridi, 2021).

Por lo tanto, una gestión central debe respaldarse para promover la innovación

y garantizar la ética y la responsabilidad, en línea con la propuesta de

Papagiannidis et al. (2022) y la perspectiva adaptativa de Taeihagh (2021).

Dilemas éticos y sesgos algorítmicos en empresas

internacionales

El uso

de la IA puede generar sesgos y prejuicios raciales y sociales debido a los

datos recopilados por los algoritmos de aprendizaje, que pueden diferir de las

prácticas actuales (Binns, 2018; Chen, 2023; Noble, 2018; Zajko, 2022). Esto es

particularmente preocupante en el caso de la contratación, donde los algoritmos

proporcionarían modelos de discriminación existentes y no marcarían una mejora (Cowgill

et al., 2020; Drage y Mackereth, 2022; Howard y Borenstein, 2018). Los

algoritmos, a menudo vistos como cajas negras, pueden obstaculizar el

rendimiento de las cuentas debido a la falta de una lógica interna integral en

muchas empresas, lo que limita su responsabilidad efectiva a la hora de mitigar

estos problemas (Barocas et al., 2023; Selbst et al., 2019; Gerards, 2022).

Personalizar

el servicio y proteger la propiedad del usuario es otro gran problema. Las

empresas que operan en todo el mundo recurren a grandes cantidades de datos

para personalizar la experiencia del usuario, lo que genera preocupación sobre

el uso indebido de los datos personales (Haleem et al., 2022; Masur y Trepte,

2021). Si bien estas prácticas de personalización pueden mejorar las

interacciones con los clientes, también exponen a las empresas a posibles

violaciones de la privacidad y a la desconfianza pública, como se vio en el

caso de Cambridge Analytica, donde se utilizó información personal sin

autorización para influir en la política y el poder judicial (Cupać y

Sienknecht, 2024; Isaak y Hanna, 2018). Estos casos resaltan la importancia de

desarrollar modelos de gestión algorítmica para controlar el uso de datos

personales y proteger la privacidad de los usuarios (Floridi y Cowls, 2019;

Raji et al., 2020).

La

principal limitación para construir una IA justa surge de la falta de

estándares internacionales, lo que dificulta asignar y asumir responsabilidades

en el mercado global y ralentiza la implementación de auditorías y monitoreo

externo (Cihon et al., 2020). Esta falta de cooperación ha llevado a muchas

empresas a evitar examinar los sistemas de IA por temor a que los sesgos puedan

dañar su reputación o llevar a mantener el control, reduciendo así los

incentivos para utilizar sistemas de control y limitando la acción a una

inteligencia más transparente y justa (Calmon Santos de Souza y Silva de Souza,

2023; Erdélyi y Goldsmith, 2022; Whittaker et al., 2018). Sin embargo, las

diferencias en la tecnología de control de las decisiones dificultan la

aplicación constante de estas prácticas en todo el mundo (Cihon et al., 2020).

En

este contexto, la gobernanza algorítmica requiere la colaboración entre

gobiernos, empresas y sociedad civil, para identificar soluciones éticas que

garanticen la transparencia y la rendición de cuentas en la adopción de

procesos de IA (Jobin et al., 2019; Saheb y Saheb, 2024; Walter, 2024). Por

ello, algunos expertos sostienen que el análisis independiente debería ser

obligatorio, especialmente en áreas importantes donde la IA puede tener un

impacto en la justicia y las relaciones, como las finanzas, la salud y los

negocios (Raji et al., 2020; Selbst et al., 2019).

Las

investigaciones muestran que la ética y la responsabilidad social de la IA

pueden, en algunos casos, utilizarse para servir a los intereses

gubernamentales en lugar de apoyar prácticas comerciales reales. Por ejemplo,

en Rusia, las grandes empresas utilizan la responsabilidad social empresarial

(RSE) como herramienta política para legitimar el poder estatal sobre las

grandes corporaciones, lo cual plantea interrogantes sobre la

instrumentalización de la ética en entornos autoritarios (Zueva y Fairbrass,

2021). Además, en un contexto global, se debe adoptar una perspectiva multidisciplinar

para implementar una IA sensible a la realidad local, además de adaptada a la

cultura y la política de cada mercado. Las soluciones basadas en algoritmos

deben tener en cuenta las diferencias culturales y contextuales para evitar la

imposición de valores occidentales en economías emergentes y asegurar que la IA

responda tanto a los derechos fundamentales como a los valores propios de cada

contexto (Ding, 2018; Floridi, 2021; Van Veldhoven y Vanthienen, 2021).

La

transparencia, la justicia y la privacidad son herramientas importantes para

resolver cuestiones éticas y promover el uso responsable de la IA en el entorno

global (Frank et al., 2023; Mucha et al., 2023; Ryan y Stahl, 2021; Schinagl y

Shahim, 2020). A largo plazo, la IA ética requiere un enfoque que combine

habilidades técnicas, de gestión y sociales, para permitir a las empresas

operar de manera más sostenible y eficaz en los mercados internacionales

(Verheij, 2020; Vesnic-Alujevic et al., 2020).

Estrategias empresariales para la adopción de IA

responsable

Para

adaptarse al crecimiento del liderazgo y la gestión, muchas empresas han

adoptado estrategias de gestión que permiten el uso de IA. Estas incluyen

comités de ética, revisiones algorítmicas e informes transparentes para

gestionar el desempeño, la gobernanza y el riesgo social (Metcalf et al.,

2019). La implementación responsable de la IA requiere incorporar estándares de

aplicación en todas las fases del ciclo de vida del desarrollo tecnológico,

desde el diseño hasta la evaluación continua (Brock y Wangenheim, 2019). En el

marketing digital, Haleem et al. (2022) hablan sobre el papel cambiante de la

IA en la personalización y mejora de la experiencia del cliente, viendo a la IA

como la clave para esa toma de decisiones en tiempo real. Esto sugiere que las

empresas deben considerar el impacto de la IA en los clientes, así como el

control interno y la ética como marco. Por su parte, Kalkan (2024) destaca las

cuestiones éticas relacionadas con la privacidad y el sesgo algorítmico, en línea

con De Laat (2021), que enfatiza la importancia del derecho del gobierno a

lograr un equilibrio entre innovación y seguridad en aplicaciones de alto

riesgo. Este enfoque enfatiza la necesidad de demostrar ética y prácticas

éticas, lo que es consistente con las recomendaciones de Gardner et al. (2022)

acerca de que las agencias de financiación deben incluir prácticas confiables

de IA en el proceso de solicitud de subvenciones, incentivando un diseño ético

desde las primeras etapas de los proyectos.

Luk

(2024) amplía este análisis en el contexto de la IA generativa, destacando que

los desafíos regulatorios actuales recuerdan los conflictos de propiedad

intelectual surgidos con Internet. En este contexto, el estudio de Cupać y

Sienknecht (2024) muestra que la IA puede suponer un peligro para los derechos

personales y el control administrativo. La UE ha desarrollado herramientas

regulatorias para reducir estos riesgos, como prohibiciones, transparencia,

gestión de riesgos y educación digital. Sin embargo, daños como la polarización

son difíciles de controlar. Esta perspectiva se complementa con la de Koskinen

et al. (2023), quienes proponen un modelo ético para la gobernanza de

ecosistemas de datos, por lo que sugieren que la transparencia y el consenso ético

entre actores pueden mitigar daños en sectores interconectados y socialmente

sensibles.

Grandes

empresas tecnológicas, como Microsoft y Amazon han avanzado hacia la adopción

de una IA responsable mediante auditorías algorítmicas y políticas de transparencia

orientadas a los consumidores (Morley et al., 2020). Sin embargo, Morley et al.

(2020) identifican una brecha entre los principios éticos y su implementación

práctica, sugiriendo que se necesita una tipología de herramientas para guiar a

los desarrolladores de IA en una práctica ética aplicada a todo el ciclo de

vida de los algoritmos. Esto resuena con Ayling y Chapman (2022), quienes

enfatizan que las herramientas éticas de la IA existentes, como las

evaluaciones de impacto y auditorías, a menudo se limitan a la autoevaluacion,

pero carecen de verificación externa, lo que es una deficiencia que debilita su

eficacia.

En

sectores altamente regulados, como el financiero, el equilibrio entre

privacidad de usuarios y procesamiento de datos masivos añade complejidad a la

adopción de principios éticos en IA (Mennella et al., 2024; Rahwan, 2018). Por

su parte, Hilb (2020) propuso cinco escenarios de gobernanza de IA en juntas

directivas, con diferentes niveles de participación de la IA, desde el servicio

hasta la autopoiesis, y enfatizó la necesidad de que los líderes empresariales

comprendan y orienten la aplicación de la IA para revolver estas cuestiones

éticas y legales. En este contexto, Taeihagh (2021) y Beulen et al. (2022)

abogan por marcos de gobernanza híbridos y adaptativos, combinando regulaciones

públicas con autorregulación privada, que resalten la importancia de contratos

formales y acuerdos relacionales en la gobernanza de IA para promover la

colaboración y confianza entre las partes. Además, Rasool et al. (2023)

encontraron que la logística inversa promueve la digitalización y la

colaboración interorganizacional, lo que facilita la ventaja competitiva a

través del intercambio de conocimientos y mejora de la cooperación entre

actores en el contexto alemán.

Con

todo, la escasez de talento especializado en ética y gobernanza algorítmica

sigue siendo una barrera para implementar políticas efectivas (Obermeyer et

al., 2019). Además, algunas empresas se han resistido al cambio debido a los

costos operativos y culturales que implica la transición hacia modelos

transparentes (Shneiderman, 2022). La cuestión de la capacidad organizativa ha

sido abordada por Akter et al. (2022), quienes sugieren que la concienciación

sobre ciberseguridad —a nivel personal, de gestión y de infraestructura— puede

ser una capacidad dinámica dentro de las empresas, que también fomenta la

resiliencia ante riesgos éticos y regulatorios.

Las

asociaciones comerciales también juegan un papel clave en la transformación

digital de sus miembros, especialmente en sectores con jugadores pequeños donde

lideran proyectos de digitalización que promueven la colaboración (Van

Veldhoven y Vanthienen, 2023); una dinámica que se alinea con los acuerdos

relacionales discutidos en la gobernanza de IA (Beulen et al., 2022). La

participación de las asociaciones comerciales en este proceso es importante

para la transformación de las empresas que operan en mercados interconectados y

orientados hacia la digitalización.

Finalmente,

aquellas empresas que invierten en marcos sólidos de gobernanza y colaboran con

gobiernos y el ámbito académico estarán mejor preparadas para enfrentar los

retos emergentes frente a la IA, como destacan Andrade y Gonçalo (2021) en su propuesta

de capacidades dinámicas para la transformación digital en países BRICS. Kalkan

(2024) menciona por su parte que la integración de gobernanza proactiva no solo

mitiga riesgos, sino que también mejora la competitividad global, mientras que

Luk (2024) subraya que la gobernanza debe anticiparse a los riesgos

tecnológicos para evitar que los avances erosionen derechos fundamentales, tal

como ocurrió en ciclos anteriores de disrupción tecnológica.

El

trabajo presentó limitaciones debido de la naturaleza cambiante del campo

regulatorio en IA, lo que implica la probabilidad de publicación de normativas

posteriores al cierre de la revisión y que las estrategias comerciales varían

entre sectores y regiones.

Conclusiones

Este

estudio ha mostrado que la adopción de la IA por parte de las empresas multinacionales

implica encontrar un equilibrio delicado entre innovación, ética y cumplimiento

normativo. Si bien la IA ofrece grandes oportunidades para optimizar procesos y

aumentar la competitividad, su integración de manera responsable enfrenta

desafíos importantes, como la fragmentación regulatoria, la falta de talento

especializado y la resistencia interna al cambio. Más aún, la ausencia de

estándares internacionales claros complica la creación de modelos de gobernanza

uniformes, lo que obliga a las empresas a ajustar sus operaciones a los

diferentes contextos locales. Sin embargo, aquellas organizaciones que

desarrollen marcos de gobernanza sólidos y colaboren tanto con actores públicos

como privados estarán mejor preparadas para enfrentar los riesgos y aprovechar

al máximo los beneficios de la IA. En última instancia, lograr una convergencia

entre ética, regulación y tecnología será esencial para consolidar la confianza

del público y asegurar que la IA contribuya de forma sostenible al desarrollo

global.

Declaración de uso de la IA

Las

ideas, argumentos, conceptos, diseño, investigación e interpretación de los

estudios incluidos en este trabajo es una creación original de los autores. Se

utilizó ChatGPT para acelerar el proceso de escritura del manuscrito, corregir

errores ortotipográficos y para traducir al inglés el título y el resumen. Los

autores revisaron la versión final para asegurar su coherencia y exactitud.

REFERENCIAS

Akter, S., Uddin, M. R., Sajib, S., Lee, W. J. T., Michael,

K., & Hossain, M. A. (2022). Reconceptualizing cybersecurity awareness

capability in the data-driven digital economy. Annals of Operations Research.

https://doi.org/10.1007/s10479-022-04816-9

Andrade, C., y Gonçalo, C. (2021). Transformación digital

habilitando capacidades estratégicas en el contexto de los “BRICS”. Revista de

Gestão, 28(4), 297-315. https://doi.org/10.1108/REGE-12-2020-0154

Ayling, J., & Chapman, A. (2022). Putting AI ethics to

work: are the tools fit for purpose? AI and Ethics, 2,

405-429. https://doi.org/10.1007/s43681-021-00084-x

Bahcecik, S. O. (2023). I TRENDS Security Politics and

Arti- ficial Intelligence: Key Trends and Debates. International Political

Science Abstracts, 73(3), 329-338. https://doi.org/10.1177/00208345231182638

Barocas, S., Hardt, M., & Narayanan, A. (2023).

Fairness and machine learning: Limitations and opportunities. MIT Press.

Beulen, E., Plugge, A., & van Hillegersberg, J. (2022).

Formal and relational governance of artificial intelligence outsourcing.

Information Systems and e-Business Management, 20, 719–748. https://doi.org/10.1007/s10257-022-00560-4

Binns, R. (2018). Fairness in machine learning: Lessons

from political philosophy. Proceedings of the 2018 Conference on Fairness,

Accountability, and Transparency, 149-159. https://doi.org/10.48550/arXiv.1712.03586

Birkstedt, T., Minkkinen, M., Tandon, A., y Mäntymäki, M.

(2023). Gobernanza de IA: temas, lagunas de conocimiento y futuras agendas.

Internet Research, 33(7), 133-167. https://doi.org/10.1108/INTR-01-2022-0042

Booth, A., Sutton, A., & Papaioannou, D. (2016).

Systematic Approaches to a Successful Literature Review (2nd ed.). SAGE

Publications.

Brock, J. M., & Wangenheim, F. (2019, Summer).

Demystifying AI: What digital transformation leaders can teach you about

realistic artificial intelligence. Business Horizons, 62(6), 751-758. https://tinyurl.com/ycyjadnr

Calmon Santos de Souza, M., & Silva de Souza, R.

(2023). Law enforcement, social demands and reputation risks as drivers of

compliance functions: A comparative analysis of the largest banks’ disclosures

in the UK and Brazil. Crime, Law and Social Change, 81(4), 255-280. https://doi.org/10.1007/s10611-023-10116-8

Chen, Z. (2023). Ethics and discrimination in artificial

intelligence-enabled recruitment practices. Humanities and Social Sciences

Communications, 10(1), 567. https://doi.org/10.1057/s41599-023-02044-8

Cihon, P., Maas, M. M., & Kemp, L. (2020, November).

Fragmentation and the future: Investigating architectures for international AI

governance. Global Policy, 11(5), 545-556. https://doi.org/10.1111/1758-5899.12890

Cowgill, B., Dell’Acqua, F., & Matz, S. (2020. May).

The Managerial Effects of Algorithmic Fairness Activism. AEA Papers and

Proceedings, 110, 85-90. https://tinyurl.com/3txk3cxw

Cupać, J., & Sienknecht, M. (2024). Regulate

against the machine: How the EU mitigates AI harm to democracy.

Democratization, 31(5), 1067-1090. https://doi.org/10.1080/13510347.2024.2353706

De Laat, P. (2021). Companies committed to responsible AI: From principles towards implementation and regulation?

Philosophy y Technology, 34, 1135-1193. https://doi.org/10.1007/s13347-021-00474-3

Díaz-Rodríguez, N., Del Ser, J., Coeckelbergh, M., López de

Prado, M., Herrera-Viedma, E., & Herrera, F. (2023, November). Connecting

the dots in trustworthy Artificial Intelligence: From AI principles, ethics,

and key requirements to responsible AI systems and regulation. Information

Fusion, 99, 101896. https://doi.org/10.1016/j.inffus.2023.101896

Dickhaut, E., Li, M. M., Janson, A., & Leimeister, J.

M. (2022). The role of design patterns in the development and legal assessment

of lawful technologies. Electronic Markets, 32, 2311-2331. https://doi.org/10.1007/s12525-022-00500-9

Ding, J. (2018, marzo). Deciphering China’s AI dream: The

context, components, capabilities, and consequences of China’s strategy to lead

the world in IA. Future of Humanity Institute, University of Oxford.

https://tinyurl.com/32emxrsd

Dignum, V. (2019). Responsible artificial intelligence: How

to develop and use AI in a responsible way. Springer. https://doi.org/10.1007/978-3-030-30371-6

Drage, E., & Mackereth, K. (2022). Does AI debias

recruitment? Race, gender, and AI’s “eradication of difference.” Philosophy y

Technology, 35(89). https://doi.org/10.1007/s13347-022-00591-w

Erdélyi, O. J., & Goldsmith, J. (2022). Regulating

artificial inte- lligence: Proposal for a global solution. Government Information

Quarterly, 39(4), 101748. https://doi.org/10.1016/j.giq.2022.101748

Espinoza, J. (2024, 15 de julio). Europe’s rushed attempt

to set the rules for AI. Financial Times. https://tinyurl.com/2p99jjs2

European Commission. (2021). Proposal for a regulation

laying down harmonised rules on artificial intelligence (Artificial

Intelligence Act). https://tinyurl.com/343v7hsa

European Union. (2016, 27 de abril). Regulation (EU)

2016/679. On the protection of natural persons with regard to the processing of

personal data and on the free movement of such data, and repealing Directive

95/46/EC (General Data Protection Regulation). EUR-Lex.

https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=uriserv:OJ.L_.2016.119.01.0001.01.ENGytoc=OJ:L:2016:119:FULL#d1e1384-1-1

Fjeld, J., Achten, N., Hilligoss, H., Nagy, A., &

Srikumar, M. (2020). Principled artificial intelligence: Mapping consensus in

ethical and rights-based approaches to principles for AI. Berkman Klein Center

Research Publication. https://doi.org/10.2139/ssrn.3518482

Floridi, L. (2021). Ethics, governance, and policies in

artificial intelligence: A road to maturity. Springer Verlag.

Frank, D.-A., Jacobsen, L.F., Søndergaard, H.A., &

Otterbring, T. (2023). In companies we trust: Consumer adoption of artificial

intelligence services and the role of trust in companies and AI autonomy.

Information Technology y People, 36(8), 155-173.

https://doi.org/10.1108/ITP-09-2022-0721

Floridi, L., & Cowls, J. (2019). A unified framework of

five principles for AI in society. Harvard Data Science Review, 1(1).

https://doi.org/10.1162/99608f92.8cd550d1

Gardner, A., Smith, A. L., Steventon, A., Coughlan, E.,

& Oldfield, M. (2022). Ethical funding for trustworthy AI: proposals to

address the responsibilities of funders to ensure that projects adhere to

trustworthy AI practice. AI and Ethics, 2, 277-291. https://doi.org/10.1007/s43681-021-00069-w

Gauthier, M. P., & Brender, N. (2021). ¿Cómo se ajustan

los estándares de auditoría actuales al uso emergente de blockchain? Managerial

Auditing Journal, 36(3), 365-385. https://doi.org/10.1108/MAJ-12-2019-2513

Gerards, J. (2022). The fundamental rights challenges of

algorithms. Netherlands Quarterly of Human Rights, 37(3), 205-209. https://doi.org/10.1177/0924051919861773

Haleem, A., Javaid, M., Qadri, M. A., Singh, R. P., &

Suman, R. (2022). Artificial intelligence (AI) applications for marketing: A

literaturebased study. International Journal of Intelligent Networks, 3,

119-132. https://doi.org/10.1016/j.ijin.2022.08.005

Hilb, M. (2020). Toward artificial governance? The role of

artificial intelligence in shaping the future of corporate governance. Journal

of Management and Governance, 24, 851-870.

https://doi.org/10.1007/s10997-020-09516-7

Howard, A., & Borenstein, J. (2018). The ugly truth

about ourselves and our robot creations: The problem of bias and social inequity.

Science and Engineering Ethics, 24(5), 1521-1536.

https://doi.org/10.1007/s11948-017-9975-2

Isaak, J., & Hanna, M. J. (2018). User data privacy:

Facebook, Cambridge Analytica, and privacy protection. Computer, 51(8), 56-59. https://doi.org/10.1109/MC.2018.3191268

Jobin, A., Ienca, M., & Vayena, E. (2019). The global

landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389-399.

https://doi.org/10.1038/s42256-019-0088-2

Kalkan, G. (2024). The Impact of Artificial Intelligence on

Corporate Governance. Journal of Corporate Finance Research /

Корпоративные

Финансы, 18(2), 17-25. https://doi.org/10.17323/j.jcfr.2073-0438.18.2.2024.17-25

Koskinen, J., Knaapi-Junnila, S., Helin, A., Rantanen,

M.M., & Hyrynsalmi, S. (2023). Ethical governance model for the data

economy ecosystems. Digital Policy, Regulation and Governance, 25(3), 221-235.

https://doi.org/10.1108/DPRG-01-2022-0005

Luk, A. (2024). The relationship between law and

technology: comparing legal responses to creators’ rights under copyright law

through safe harbour for online intermediaries and generative AI technology.

Law, Innovation and Technology, 16(1), 148-169. https://doi.org/10.1080/17579961.2024.23.13800

Lappi, T. M., Aaltonen, K., & Kujala, J. (2019).

Project governance and portfolio management in government digitalization.

Transforming Government: People, Process and Policy, 13(2), 159-196. https://doi.org/10.1108/TG-11-2018-0068

Masur, P. K., & Trepte, S. (2021). Transformative or

not? How privacy violation experiences influence online privacy concerns and

online information disclosure. Human Communication Research, 47(1), 49–74. https://doi.org/10.1093/hcr/hqaa012Mennella,

C., Maniscalco, U., De Pietro, G., & Esposito, M. (2024). Ethical and

regulatory challenges of AI technologies in healthcare: A narrative review.

Heliyon, 10(4), e26297. https://doi.org/10.1016/j.heliyon.2024.e26297

Metcalf, J., Moss, E., & Boyd, D. (2019). Owning

ethics: Corporate logics, Silicon Valley, and the institutionalization of

ethics. Social Research: An International Quarterly, 82(2), 449-476.

https://muse.jhu.edu/article/732185

Mozur, P., Kessel, J. M., & Chan, M. (2019). Made in

China, exported to the world: The surveillance state. The New York Times.

https://tinyurl.com/2dxtv5c8

Morley, J., Floridi, L., Kinsey, L., & Elhalal, A.

(2020). From what to how: An initial review of publicly available AI ethics

tools, methods, and research to translate principles into practices. Science

and Engineering Ethics, 26, 2141-2168. https://doi.org/10.1007/s11948-019-00165-5

Mucha, T., Ma, S., & Abhari, K. (2023). Riding a

bicycle while building its wheels: The process of machine learning-based

capability development and IT-business alignment practices. Internet Research,

33(7), 168-205. https://doi.org/10.1108/INTR-10-2022-0769

National Institute of Standards and Technology (NIST).

(2024). Artificial intelligence risk management framework: Generative

artificial intelligence profile (NIST AI 600-1). U.S. Department of Commerce.

https://doi.org/10.6028/NIST.AI.600-1

Noble, S. U. (2018). Algorithms of oppression: How search

engines reinforce racism. NYU Press. https://tinyurl.com/56ex47f5

Obermeyer, Z., Powers, B., Vogeli, C., & Mullainathan,

S. (2019). Dissecting racial bias in an algorithm used to manage the health of

populations. Science, 366(6464), 447-453. https://doi.org/10.1126/science.aax2342

Park, E. (2023). The AI Bill of Rights: A step in the right

direction. Orange County Lawyer Magazine, 65(2), 25. https://ssrn.com/abstract=4351423

Pflanzer, M., Dubljević, V., Bauer, W. A., Orcutt, D.,

List, G., & Singh, M. P. (2023). Embedding AI in society: ethics, policy,

governance, and impacts. AI y Society, 38, 1267-1271. https://doi.org/10.1007/s00146-023-01704-2

Papagiannidis, E., Enholm, I. M., Dremel, C., Mikalef, P.,

& Krogstie, J. (2022). Toward AI Governance: Identifying Best Practices

and Potential Barriers and Outcomes. Information Systems Frontiers, 25,

123-141. https://doi.org/10.1007/s10796-022-10210-1

Rahwan, I. (2018). Society-in-the-loop: Programming the

algorithmic social contract. Ethics and Information Technology, 20, 5-14. https://doi.org/10.1007/s10676-017-9430-8

Raji, I. D., Smart, A., White, R. N., Mitchell, M., Gebru,

T., Hutchinson, B., Smith-Loud, J., Theron, D., & Barnes, P. (2020).

Closing the AI accountability gap: Defining an end-to-end framework for

internal algorithmic auditing. In FAT ‘20: Proceedings of the 2020 Conference

on Fairness, Accountability, and Transparency (pp. 33-44). Association for

Computing Machinery. https://doi.org/10.1145/3351095.3372873

Rana, G., Khang, A., Sharma, R., Kumar, A. l., & Kumar,

A. S. (2022). Reinventing Manufacturing and Business Processes Through

Artificial Intelligence. CRC Press.

Rasool, F., Greco, M., Morales-Alonso, G., & Carrasco-Gallego, R. (2023). What is next? The effect of reverse

logistics adop- tion on digitalization and inter-organizational collaboration.

International Journal of Physical Distribution y Logistics Management, 53(5/6),

563-588. https://doi.org/10.1108/ IJPDLM-06-2022-0173

Roberts, H., Cowls, J., Hine, E., Morley, J., Wang, V.,

Taddeo, M., & Floridi, L. (2023). Governing artificial intelligence in

China and the European Union: Comparing aims and promoting ethical outcomes.

The Information Society, 39(2), 79-97. https://doi.org/10.1080/01972243.2022.2124565

Roberts, H., Cowls, J., Morley, J., Taddeo, M., Wang, V.,

& Floridi, L. (2021). The Chinese approach to artificial intelligence: An

analysis of policy, ethics, and regulation. AI y Society, 36(1), 59-77. https://doi.org/10.1007/s00146-020-00992-2

Ryan, M., & Stahl, B. C. (2021). Artificial

intelligence ethics guidelines for developers and users: clarifying their

content and normative implications. Journal of Information, Communication and

Ethics in Society, 19(1), 61-86. https://doi.org/10.1108/JICES-12-2019-0138

Saheb, T., & Saheb, T. (2024). Mapping Ethical

Artificial Intelligence Policy Landscape: A Mixed Method Analysis. Science and

engineering ethics, 30(2), 9. https://doi.org/10.1007/s11948-024-00472-6

Salo-Pöntinen, H., & Saariluoma, P. (2022). Reflections

on the human role in AI policy formulations: how do national

AI strategies view people? Discov Artificial Intelligence, 2(3).

https://doi.org/10.1007/s44163-022-00019-3

Schinagl, S., & Shahim, A. (2020). What do we know

about information security governance? “From the basement to the boardroom”:

towards digital security governance. Information and Computer Security, 28(2),

261-292. https://doi.org/10.1108/ICS-02-2019-0033

Selbst, A. D., Boyd, D., Friedler, S. A., Venkatasubramanian,

S., & Vertesi, J. (2019). Fairness and abstraction in sociotechnical

systems. In FAT ‘19: Proceedings of the Conference on Fairness, Accountability,

and Transparency (pp. 59-68). Association for Computing Machinery. https://doi.org/10.1145/3287560.3287598

Shneiderman, B. (2022). Human-centered AI. Oxford

University Press. https://tinyurl.com/3k6dpzad

Simbar, R., & Moghadam Lakani, S. F. (2022). Changes in

the balance of international power in the light of China’s artificial intelligence.

Journal of World Sociopolitical Studies, 36, 59-77. https://doi.org/10.22059/wsps.2022.336553.1268

Taeihagh, A. (2021). Governance of artificial intelligence.

Policy and Society, 40(2), 137-157. https://doi.org/10.1080/14494035.2021.1928377

Van Veldhoven, Z., & Vanthienen, J. (2021). Digital

transformation as an interaction-driven perspective between business, society,

and technology. Electronic Markets, 32, 629-644.

https://doi.org/10.1007/s12525-021-00469-0

Van Veldhoven, Z., & Vanthienen, J. (2023). The role of

trade associations in the digital transformation of their industry. Digital

Transformation and Society, 2(3), 235-256. https://doi.org/10.1108/DTS-11-2022-0058

Verheij, B. (2020). Artificial intelligence as law.

Artificial Intelligence and Law, 28(2), 181-206.

https://doi.org/10.1007/s10506-020-09266-0

Veale, M., & Zuiderveen, F. (2021). Demystifying the

Draft EU Artificial Intelligence Act-Analysing the good, the bad, and the

unclear elements of the proposed approach. Computer Law Review International,

22(4), 97-112. https://doi.org/10.9785/cri-2021-220402

Vesnic-Alujevic, L., Nascimento, S., & Pólvora, A.

(2020). Societal and ethical impacts of artificial intelligence: Critical notes

on European policy frameworks. Telecommunications Policy, 44(6), 101961. https://doi.org/10.1016/j.telpol.2020.101961

Walter, Y. (2024). Managing the race to the moon: Global

policy and governance in Artificial Intelligence regulation – A contemporary

overview and an analysis of socioeconomic consequences. Discover Artificial

Intellifence, 4(14), https://doi.org/10.1007/s44163-024-00109-4

Whittaker, M., Crawford, K., Dobbe, R., Fried, G., Kaiunas,

E., Mathur, V., Myers, S., Richardson, R., Schultz, J., & Schwartz, O.

(2018, diciembre). AI Now Report 2018. IA Now Institute. https://tinyurl.com/8v98uvas

Zajko, M. (2022, March). Artificial intelligence,

algorithms, and social inequality: Sociological contributions to contemporary

debates. Sociology Compass, 16(2), e12962. https://doi.org/10.1111/soc4.12962

Zueva, A., & Fairbrass, J. (2021). Politicising

Government Engagement with Corporate Social Responsibility: “CSR” as an Empty

Signifier. Journal of Business Ethics, 170, 635-655.

https://doi.org/10.1007/s10551-019-04330-5

Contribución de los autores

DDOI:

conceptualización, metodología, redacción del borrador inicial, análisis

formal, supervisión, administración del proyecto, visualización y revisión

final del artículo.

CXPP:

investigación, recopilación de datos, revisión del manuscrito, redacción,

revisión y edición, recursos y validación.

Fuentes de financiamiento

El

estudio fue autofinanciado.

Conflictos de interés

Los

autores declaran no tener conflictos de interés.

Correspondencia

Darwin

Daniel Ordoñez Iturralde

Avenida

de Las Américas #70 frente al Cuartel Modelo,

Guayaquil,

Ecuador.

+593992882503

dordonezy@ulvr.edu.ec